Итак, стоит задача настроить анализатор логов nginx-сервера goaccess таким образом, чтобы оно отображало статистику в реальном времени (для этого будем использовать веб-сокеты). Статистика должна быть доступна по адресу https://website1.example.com/goaccess

Далее – создать systemd-юниты для автоматизации процесса. Дополнительные задачи: настроить goaccess для второго сайта на том же сервере (https://website2.example.com/goaccess). Два процесса goaccess должны работать параллельно (для этого будем использовать встроенные опции именованных каналов межпроцессного взаимодействия, указание на путь хранения базы данных программой goaccess, а также укажем другой порт). Также установить ограничений по ip-адресам для доступа к панели статистики второго сайта (с помощью конфигурации nginx).

Предположим, что goaccess уже установлен. Нам нужно просматривать статистику по логам /var/log/nginx/website1/access.log по адресу https://website1.example.com/goaccess/main.html. HTML-страница со статистикой для https://website1.example.com будет храниться здесь: /var/www/goaccess/website1. Далее нам потребуется настроить nginx. Для этого в конфиге сайта (/etc/nginx/sites-available/website1) нужно добавить две локации: stats и ws:

location /stats/ {

alias /var/www/goaccess/website1/;

try_files $uri $uri/ =404;

}вкратце, этот блок конфигурации Nginx настроен на обработку запросов, начинающихся с “/stats/”. Он сопоставляет эти запросы с локальным каталогом на сервере и пытается предоставить запрашиваемый файл или каталог, возвращаясь к ошибке 404, если таковой не существует.

Далее нужно настроить веб-сокет:

location /ws/ {

# порт не должен блокироваться фаерволом

proxy_pass http://localhost:7890/;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "Upgrade";

proxy_set_header Host $host;

}Релоадим конфигурацию nginx:

sudo systemctl reload nginx

этот блок перенаправляет http-реквесты с https://website1.example.com/ws на http://localhost:7890 и устанавливает необходимые заголовки для работы с веб-сокетами.

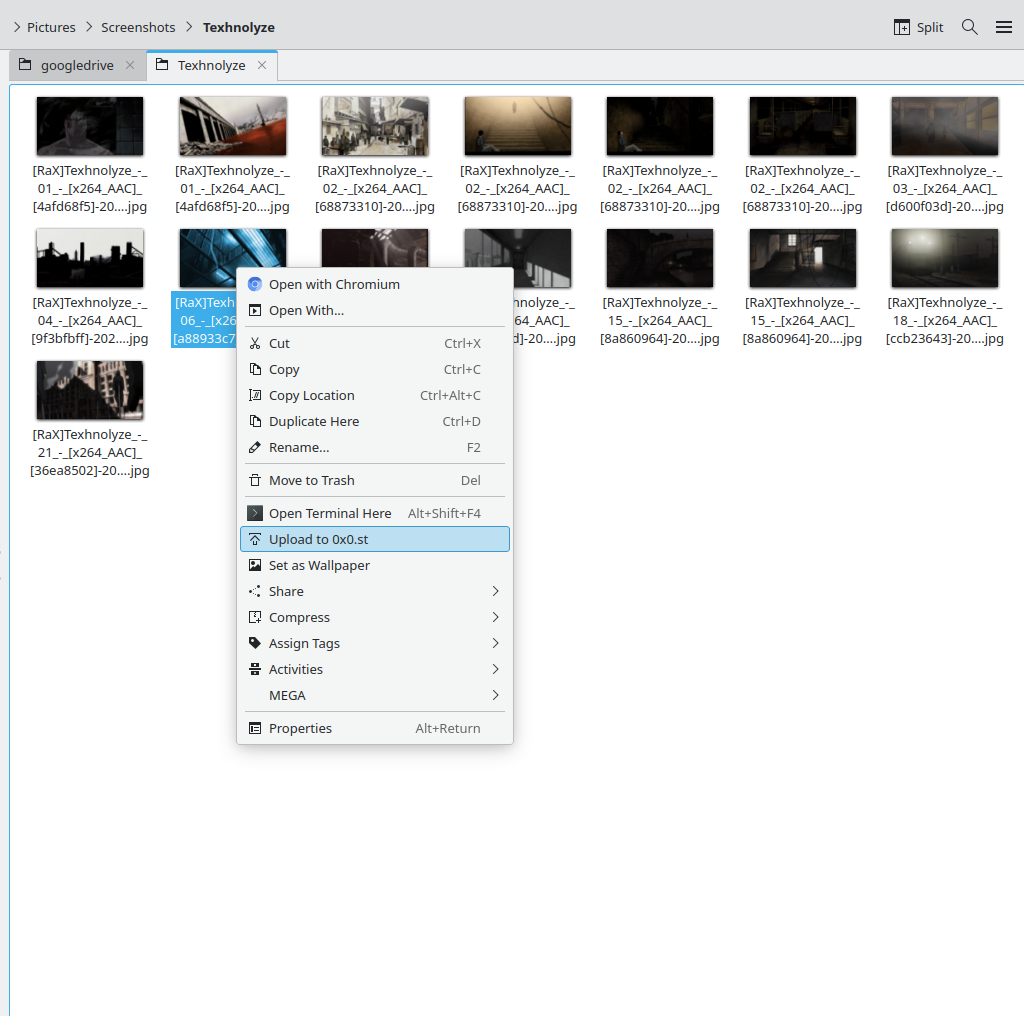

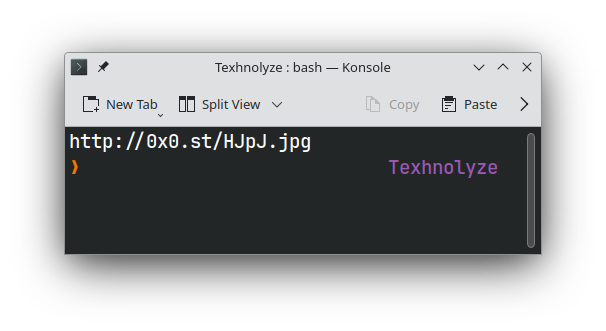

Запуск команды для проверки что все работает:

goaccess /var/log/nginx/website1/access.log -o /var/www/goaccess/website1/main.html --real-time-html --port=7890 --log-format=COMBINED --ws-url=wss://eiensora.bernd32.xyz/ws/:443Порт 443 предполагает, что у нас настроено https.

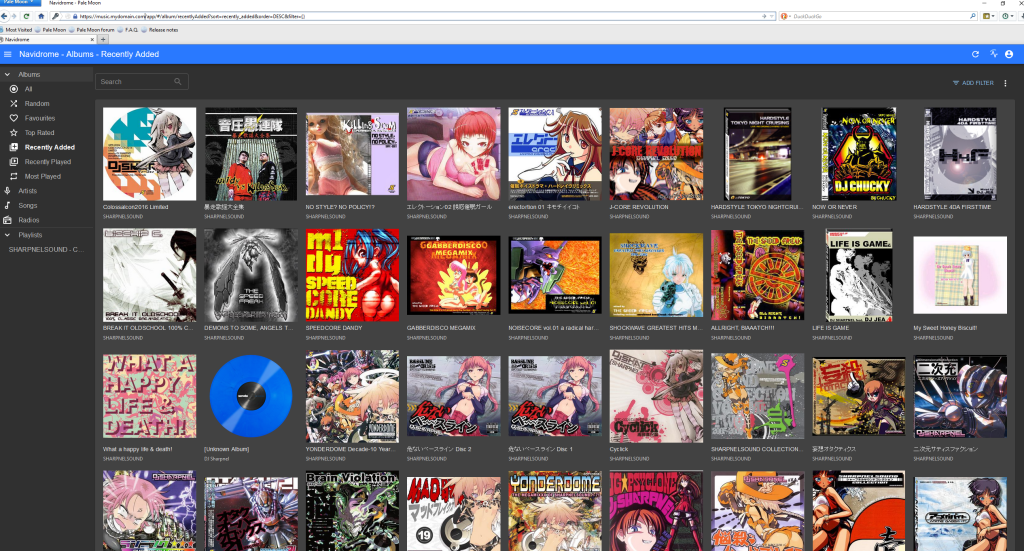

Заходим https://website1.example.com/goaccess/main.html и смотрим. Если все ок, то добавим systemd-юнит:

vim /etc/systemd/system/goaccess_website1.service:

[Unit]

Description=GoAccess Live Log Analyzer for website1

[Service]

Type=simple

ExecStart=goaccess /var/log/nginx/website1/access.log \

-o /var/www/goaccess/website1/main.html \

--real-time-html \

--port=7890 \

--log-format=COMBINED \

--ws-url=wss://website1.example.com/ws/:443

ExecStop=/bin/kill ${MAINPID}

PrivateTmp=false

RestartSec=1800

User=root

Group=root

Restart=always

[Install]

WantedBy=multi-user.targetsudo systemctl daemon-reload

sudo systemctl start goaccess_website1

sudo systemctl enable goaccess_website1Для одного сайта всё должно работать ок. Если нужно мониторить несколько разных логов (скажем, от разных сайтов, которые находятся на одном сервере) одновременно на разных адресах. То есть нам нужно запустить каким-то образом запустить два параллельных процесса goaccess. Сделать это можно, если

– запускать каждый процессор goaccess на разных портах –port.

– Различные каналы (FIFO) –fifo-in=/path/in.1 –fifo-out=/path/out.1.

– Если вы используете хранилище на диске, вам понадобится другой путь, по которому хранятся файлы БД –db-path=/path/instance1/.

Нужно изменить предыдущий юнит и добавить новые опции

–fifo-in=/tmp/es.in \

–fifo-out=/tmp/es.out \

–db-path=/var/lib/goaccess/

[Unit]

Description=GoAccess Live Log Analyzer for website1

[Service]

Type=simple

ExecStart=goaccess /var/log/nginx/website1/access.log \

-o /var/www/goaccess/website1/main.html \

--real-time-html \

--port=7890 \

--log-format=COMBINED \

--ws-url=wss://website1.example.com/ws/:443 \

--fifo-in=/tmp/site1.in \

--fifo-out=/tmp/site1.out \

--db-path=/var/lib/goaccess/website1

ExecStop=/bin/kill ${MAINPID}

PrivateTmp=false

RestartSec=1800

User=root

Group=root

Restart=always

[Install]

WantedBy=multi-user.targetsudo systemctl daemon-reload

sudo systemctl start goaccess_website1

sudo systemctl enable goaccess_website1Значения fifo и db-path можно выбрать какие-угодно.

Далее, добавить второй юнит для статистики второго сайта, в котором будет другой порт, другое значение параметров –db-path, –fifo-in и –fifo-out:

vim /etc/systemd/system/goaccess_website2.service:

[Unit]

Description=GoAccess Live Log Analyzer for website2

[Service]

Type=simple

ExecStart=goaccess /var/log/nginx/website2/access.log \

-o /var/www/goaccess/website2/main.html \

--real-time-html --port=7891 \

--log-format=COMBINED \

--ws-url=wss://website1.example.com/ws/:443 \

--fifo-in=/tmp/site2.in \

--fifo-out=/tmp/site2.out \

--db-path=/var/lib/goaccess/website2/

ExecStop=/bin/kill ${MAINPID}

PrivateTmp=false

RestartSec=1800

User=root

Group=root

Restart=always

[Install]

WantedBy=multi-user.targetТакже не забыть добавить в конфиг /etc/nginx/sites-available/website2:

location /stats/ {

alias /var/www/goaccess/website2/;

try_files $uri $uri/ =404;

#даем доступ к статистике только локальной подсетке и одному внешнему айпи

allow 44.51.220.3;

allow 192.168.1.0/24;

deny all;

}

location /ws/ {

# порт должен отличаться от созданного первого юнита

proxy_pass http://localhost:7891/;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "Upgrade";

proxy_set_header Host $host;

}sudo systemctl daemon-reload

sudo systemctl start goaccess_website2

sudo systemctl enable goaccess_website2Теперь панели просмотра goaccess разных сайтов будут доступны одновременно по двум адресам:

https://website1.example.com/goaccess/main.html

https://website2.example.com/goaccess/main.html